서론

현재 교통 안전성 평가 방법에는 기존부터 널리 사용된 교통사고 자료뿐 아니라 차량에 설치된 내비게이션, 운행기록장치(Digital Tacho Graph; DTG), GPS 자료 등을 활용하고 있다. 하지만 교통사고 자료의 경우 분석을 수행하기 위하여 필요한 사고 건수가 축적되기까지 3년 이상의 오랜 시간이 소요되는 단점이 있으며, 내비게이션 데이터의 경우 통신사를 경유하지 않으면 취득하기 어려운 접근성 문제가 존재한다. DTG 데이터는 사업용 차량에만 설치되어 있어 일반 운전자의 주행 특성을 대표하는 것에 한계점이 존재하며, GPS 데이터는 교통사고 분석을 보조하는 역할로 주로 활용되고 있다. 이러한 데이터들은 무엇보다 사고 발생 직정의 상황을 파악하는데 한계점을 보이고 있다.

블랙박스 영상의 경우, 사고 발생 직전의 상황을 파악하는데 있어서 다른 데이터보다 장점을 갖고 있어, 이를 활용한 교통안 안전성 평가가 필요하다. 블랙박스 영상의 경우 차량 소유주의 동의를 얻으면 사고 영상을 취득할 수 있으며, 교통사고 과실 비율을 판단하기 위하여 많이 활용되는 등 교통 안전성 분석을 위한 새로운 매개체로 떠오르고 있다. 또한, 2022년 기준 국내 블랙박스 보급률은 100%에 육박하는 것으로 나타나 모든 차량에 설치되어 있음을 알 수 있다.

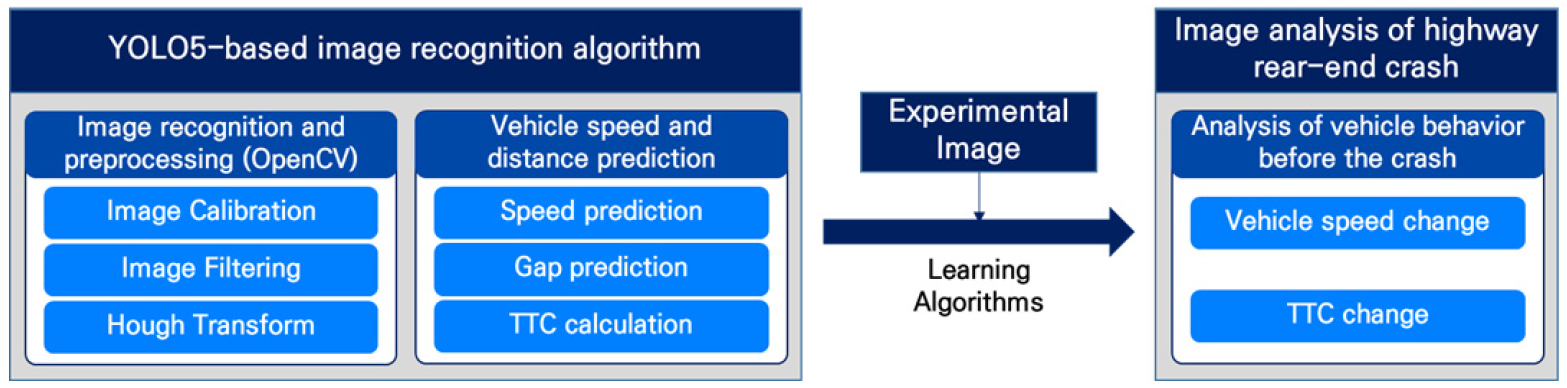

본 연구의 목적은 이러한 블랙박스 영상을 이용하여 영상인식방법을 활용하여 후미추돌 교통사고 발생 시, 사고 직전의 선행 및 후행 차량의 움직임을 분석하고, 이를 바탕으로 블랙박스 영상 기반 주행안전성 평가방법론을 개발하는 것이다. 제안된 방법론은 카메라 영상을 활용하는 자율주행차의 사고 회피 및 대응을 위한 기초자료를 구축하는 데 폭넓게 사용될 수 있다. 본 연구를 수행하기 위하여 YOLO5 및 OpenCV에 기반하여 블랙박스 영상을 전처리하고, 후행 차량의 속도 및 선행 차량과의 거리를 예측하여 차량 속도를 계산하는 알고리즘을 개발하고 실험주행을 통한 알고리즘 학습을 진행하였다. 그리고 학습된 알고리즘을 실제 후미추돌 교통사고 영상에 반영하여 교통사고 발생 직전의 차량속도 및 TTC를 산출하여 후미추돌 사고 발생 직전의 차량 행태에 대한 분석을 수행하였다. 이러한 연구 흐름은 아래 Figure 1으로 구성된다.

선행연구

본 연구를 수행하기에 앞서 영상인식 알고리즘 개발을 위하여 영상정보를 인식하여 차량의 속도 및 차간 거리를 추정하는 기존 연구를 고찰하였다. Czajewski and Iwanowski(2010) 및 Dehghani and Parsayan(2013)는 CCTV 촬영 화면을 통하여 차량 주행속도를 추정하는 알고리즘을 제안하였다. 영상에 가상의 플레이트 영역을 설정하고, 차량에 해당하는 객체를 추출하여 해당 영역의 진입 시점의 프레임과 진출시점 프레임을 이용하여 속도를 추정하였다. Kim and Cho(2012), Park et al.(2015) 및 Park et al.(2023)은 영상 센서를 이용한 차량 검출 및 차간거리 추정 알고리즘을 제시하였다. 제시된 알고리즘에서 차간 거리 추정을 위하여 차량 폭과 카메라의 초점 거리에 기반하여 차간 거리를 추정하는 방법과 차량에 설치된 카메라의 위치와 각도를 고려한 차간거리 추정 방법을 사용하였다. Kim and Kang(2012)은 차량의 그림자와 뒷바퀴, 후미등의 색상 변화를 이용하여 차간 거리를 측정하는 방법을 제안하였다. 또한, 그레이스케일 영상으로 변환된 영상을 소벨 연산과 이진화를 거쳐서 나온 차선 에지의 픽셀에 대해 허프변환을 수행하여 차선을 검출하는 알고리즘도 제시하였다. Jeong(2014)은 실제 카메라를 이용하여 측정 거리별로 픽셀 수를 계산하여 차간 거리를 측정하는 방법론을 제안하였다. Han and Park(2017)은 차량의 그림자와 후미등을 이용하여 차량을 검출하고 검출된 차량의 폭을 이용하여 차간거리를 추정하는 방법을 제시하였다. Ko(2018)는 블랙박스에 저장된 영상 이미지를 분석하여 두 차량의 거리가 좁아지는 비율과 전방 차량의 번호판 길이가 증가하는 비율이 같음을 이용하여 저속영역의 추돌 속도를 연산하는 알고리즘을 제안하였다.

안전성 평가 방법론 개발을 위하여 평가지표와 관련된 기존 연구를 고찰하였다. 대리안전지표는 교통상충기법을 응용하여 차량추종 및 차로변경을 분석하여 교통사고의 발생 가능성을 계량화하여 나타내는 지표로(Oh et al., 2009) 실제 사고가 발생하지 않은 상황에서 안전성을 평가할 수 있는 장점이 존재하며 교통류 관리전략의 안전성 평가를 위해 다양하게 활용되고 있다. Cunto and Saccomanno(2008)은 교통류 시뮬레이션 프로그램인 VISSIM을 이용하여 개별 차량의 안전 성능을 추정하기 위하여 신호교차로에서의 후미추돌 발생 가능성에 대해 연구를 수행하였다. Gousios and Garber(2009)는 교통류 시뮬레이션 프로그램인 PARAMICS를 이용하여 TTC의 다양한 임계값에 대한 예상 사고 건수를 산출하고 민감도 분석을 통하여 TTC 임계값을 정하는 연구를 수행하였다. Calvi et al.(2020)은 자율주행차량과 비자율주행차량에 탑승한 운전자의 특성과 차량의 거동 분석을 위하여 대리안전지표를 활용하여 시나리오에 대한 분석을 수행하였으며, 자율주행 모드에서 운전자가 제어권을 받아 운전을 재개할 때 운전자는 조심스럽고 위험한 행동을 모두 보인다는 결과를 도출하였다. Ko et al.(2021)은 커넥티드 차량의 전방 위험상황 경고 정보가 제공되었을 때 속도 및 대리안전지표를 활용하여 커넥티드 차량의 충돌 가능성을 정량화하는 연구를 수행하였으며, 경고정보 제공 시 속도는 10.2% 감소하고 TTC는 5.3% 증가한 결과를 도출하였다.

기존 문헌을 고찰한 결과, 속도 추정을 하는 방법으로 사전에 지정된 영역 내의 특정 거리를 통과하는데 소요되는 시간을 기반으로 하는 방법이 다수 연구되었다. 본 연구에서도 고정된 거리 값을 사용하기 위하여 차선 도색의 길이를 활용하여 분석하여 기존 연구에서 진행된 고정된 객체 기반이 아닌 영상 상에서 이동하고 있는 객체 기반 속도 추정 알고리즘을 제안하는 점이 차이가 있다. 또한, 기존 연구에서 다양한 객체를 기준값으로 설정하여 거리를 측정하는 방법이 제시되었으며, 대부분의 연구에서는 객체의 너비, 초점거리 등을 활용한 동일한 방법론에 기반하여 분석한 것으로 나타났다. 다만, 대부분의 연구에서는 차량 거리를 추정하는 방법에 대한 연구 중심으로 수행되어, 추정된 차량 거리를 이용하여 후속 분석을 수행하는 경우가 드물었다. 본 연구는 차간 거리 및 속도를 추정하여 TTC와 같은 안전지표를 산출한다는 점에서 기존 연구와는 차별성을 지닌다.

블랙박스 영상을 활용한 분석자료 추출

블랙박스 영상을 전처리하고 분석하기 위하여 영상인식 알고리즘을 개발하였다. 영상을 분석하기 위하여 전처리 과정을 수행한다. 먼저 Calibration 과정은 블랙박스 영상의 카메라별 왜곡 발생에 따른 영상을 보정하기 위한 과정이다. 일반적으로 동일한 카메라에 촬영된 일정한 간격의 기준 이미지를 사용하여 볼록 또는 오목하게 왜곡된 정도에 따라 왜곡 계수를 추정하고, 이를 영상에 반대로 부여하여 평면적 영상을 도출한다. 이 과정에서 중요한 것은 동일한 카메라로 기존에 촬영된 이미지가 없으면 보정이 불가하다는 점이며, 정확한 분석을 위해서는 각 블랙박스 촬영 장비 별로 보정된 값을 산출하는 과정이 필요하다. 본 연구에서는 실험 주행에 사용된 블랙박스 카메라 장비를 기준값으로 설정하여 보정을 진행하였다.

다음으로 Filtering은 영상의 밝기, 색상 및 상태에 따른 차선 인식의 정확도를 높이기 위하여 수행하는 과정이다. 이 과정에는 노이즈 제거(blur), 외곽선(edge) 추출, 비외곽선(non-edge) 제거 등 목적에 따른 다양한 필터를 사용하며, 노란색 또는 흰색과 같은 특정 색상을 추출하는 단계이다. 본 연구에서는 이미지의 노이즈 제거를 위한 가우시안 필터(Gaussian blur)와 외곽선 추출을 위한 canny edge 검출 방법론을 적용하였다. 외곽선이 추출된 이미지에서 차선 인식을 위해 필요한 직선의 범위 외 부분을 삭제하는 허프 변환(hough transform)을 적용하여 외곽선에서 직선 선분을 추출하여 연결하여 이미지 필터링을 적용하였다.

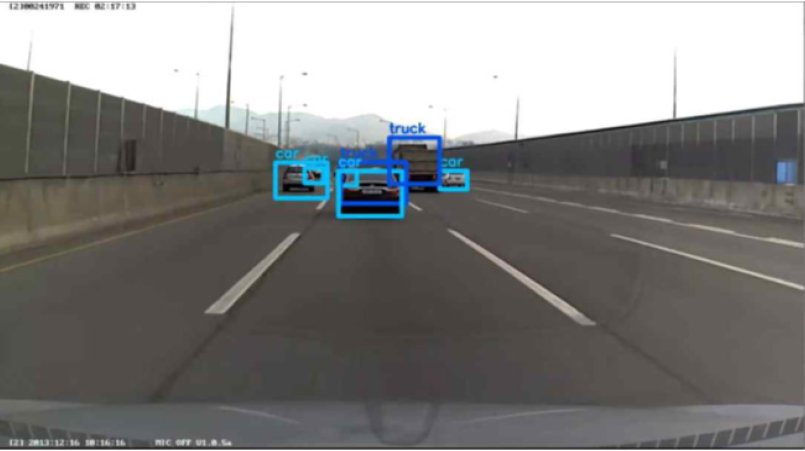

허프 변환을 통해 추출한 선으로부터 좌우 차선에 있을 가능성이 있는 직선들만 따로 추출하여 하나의 직선으로 변환하는 과정을 수행한다. 검출된 허프 변환 직선들의 기울기를 계산하여 기울기에 따라 좌, 우 차선으로 분류하고, 선형 회귀를 통해 각각의 가장 적합한 차선을 추출하였으며, Figure 2의 형태로 하나의 직선으로 나타나게 되며, 각 직선의 방정식을 기반으로 영상 내에서의 소실점을 찾는 것이 가능하다. 이후 실시간 다중 객체 추적을 할 수 있는 norfair를 사용하여 전방 객체 인식 및 추적 과정을 통해 블랙박스 영상 내의 차량을 Figure 3와 같이 개별적으로 인식한다.

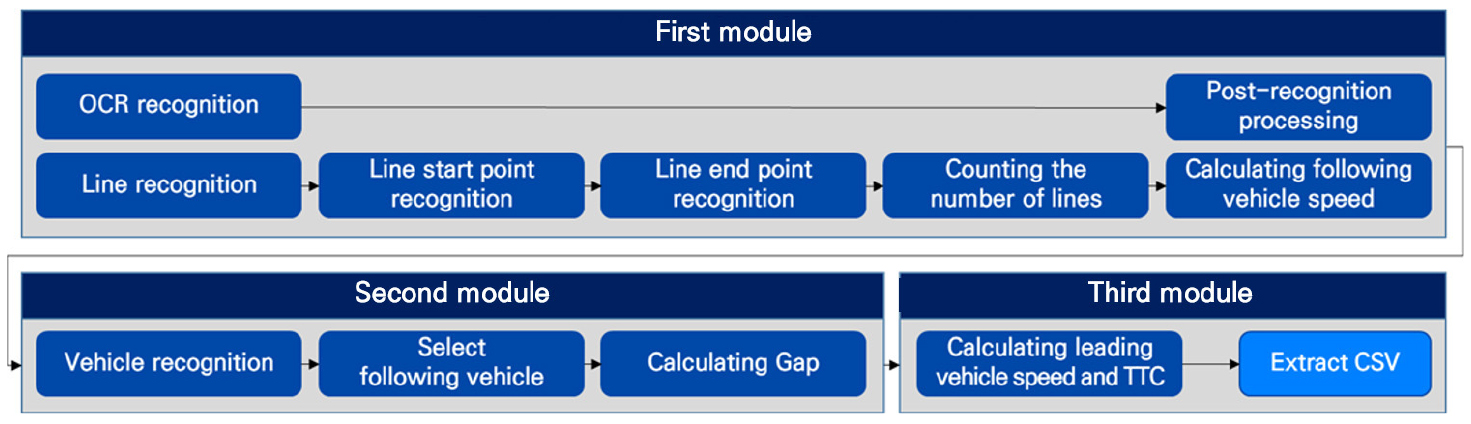

전처리된 블랙박스 영상 내에서 선행‧후행 차량 속도 및 차간거리 추정을 위한 알고리즘을 개발하였다. 알고리즘은 총 3단계의 모듈을 통해 구현하였다. 우선 후행 차량 속도 예측 모듈에서는 전처리 과정을 통해 구현된 차선 인식 과정을 통하여 차선의 시작점과 끝점을 인식하고, 차선 개수를 누적시켜 특정 시간에 통과한 차선 개수를 산출하는 방식을 통하여 후행 차량 속도를 계산한다. 다음으로는 선행-후행 차량 거리 예측 모듈로, 영상에 촬영된 선행 차량을 인식하고, 중심선 거리 기준과 영역 크기 기준에 따라 같은 차로 상에 주행 중인 전방의 선행 차량을 인식한 후, 선행 차량 폭 값의 변화량을 이용하여 거리를 추정한다. 마지막으로 선행 차량 속도 예측 모듈에서는 후행 차량 속도와 차량 간 거리를 이용하여 선행 차량의 속도를 예측한다. 3단계 모듈을 통해 추정된 선행‧후행 차량 속도 및 차간거리 추정 값을 이용하여 TTC 값을 산출한다. 이러한 예측 알고리즘 모듈 구현 방식을 Figure 4에 나타내었다.

첫 번째 모듈인 후행 차량 속도 예측에서는 블랙박스 영상 내의 문자를 인식하기 위하여 OCR(Optical Character Recognition, 광학 문자 인식) 및 인식 후 처리 과정을 진행한다. OCR은 사람이 쓰거나 기계로 인쇄한 문자의 영상을 이미지 스캐너로 획득하여 기계가 읽을 수 있는 문자로 변환하는 것을 의미한다. 본 연구에서는 EasyOCR 알고리즘을 적용하여 블랙박스 영상 내 문자를 인식하였으며, 숫자 5가 알파벳 S로 인식되는 등 잘못 인식되는 내용을 수정하기 위하여 인식 후처리 과정을 적용하였다. 또한, 블랙박스 영상 내의 차선을 인식하기 위하여 가우시안 필터, canny edge 추출 및 허프 변환의 영상인식 알고리즘이 적용된 이미지를 활용하였다. 영상 내에서 주행 차량이 위치한 차로의 좌우 차선의 시작점 및 끝점을 인식하고, 프레임별로 차선 여부를 확인하여 10초 동안 인식된 차선의 개수를 통하여 블랙박스 영상을 촬영한 후행 차량의 속도를 계산하였다. 차선의 길이는 교통노면표시 설치‧관리 업무편람(National Police Agency, 2022)에 명시된 차선 도색 길이 기준을 적용하였으며, 차선 길이에 대한 권장 표준규격은 Table 1과 같으며, 도시부 도로에서는 차선의 시작점에서 다음 차선의 시작점까지 8m 간격이며, 고속도로에서는 20m 간격이 적용되는 것으로 나타났다. 하지만 2022년 이전에 개통한 많은 도로 구간에서는 기존 내용 및 도로교통법 시행규칙 별표6에서 명시한 도색 길이 300-1,000cm, 공백 길이는 도색 길이의 1-2배 적용으로 시공되어 있다(Road Traffic Act Enforcement Rules, 2023). 도시부 구간에서는 주로 4-8m가 다양하게 적용된 것을 확인하였으며, 고속도로의 경우 20m 간격은 동일하나 도색길이 구간이 8m인 경우와 10m인 경우가 혼재되어 있는 것을 확인하였다. 따라서 본 연구에서는 알고리즘 학습과정 및 실사고 적용 시 각 구간별 도색길이에 대한 조사를 수행하여 분석에 적용하였다.

Table 1.

Standard lane length

| Road type | Standard painted lane length | Standard empty lane length |

| Urban road | 300cm | 500cm |

| Rural road | 500cm | 800cm |

| Highway | 1,000cm | 1,000cm |

두 번째 모듈인 선행-후행 차량 거리 예측에서는 중심선 거리를 이용하여 같은 차로 상의 선행 차량을 인식하고 차량 폭 값의 변화량을 이용하여 거리를 예측하는 과정을 수행한다. 우선 블랙박스 영상에 촬영된 전방의 차량에 대해 norfair의 전방 객체 인식 및 추적 과정 기능을 적용하여 car, bus, truck의 3종류 차종으로 분류한다. 이후, 중심선 거리 및 객체 크기를 같이 고려하여 같은 차로 상에 주행 중인 선행 차량을 인식한다. 중심선 거리를 적용하지 않고 객체 크기만을 고려하여 선행 차량을 인식할 때는 전방에 주행 중인 승용차보다 옆 차로에서 주행 중인 트럭, 버스가 더 크게 인식되어 선행 차량을 잘못 인식하는 문제가 발생할 수 있으며, 중심선 거리만을 고려하여 선행 차량을 인식할 때는 곡선부 구간에서의 인식률 저하 문제가 발생하는 문제점이 존재한다. 인식된 선행 차량의 프레임별 차량 폭 값의 변화량을 이용하여 선행 차량과 블랙박스 영상이 촬영된 후행 차량의 차량 간 거리를 추정한다. 차량 번호판을 이용할 경우 마지막 모듈에서는 첫 번째 모듈에서 추정한 후행 차량 속도와 두 번째 모듈에서 추정한 차량 간 거리를 이용하여 선행 차량의 속도를 예측한다. 그리고 예측된 선행‧후행 차량의 속도와 차량 간 거리를 이용하여 TTC 값을 1초 단위로 가공하여 도출한다.

알고리즘 학습 및 실증분석

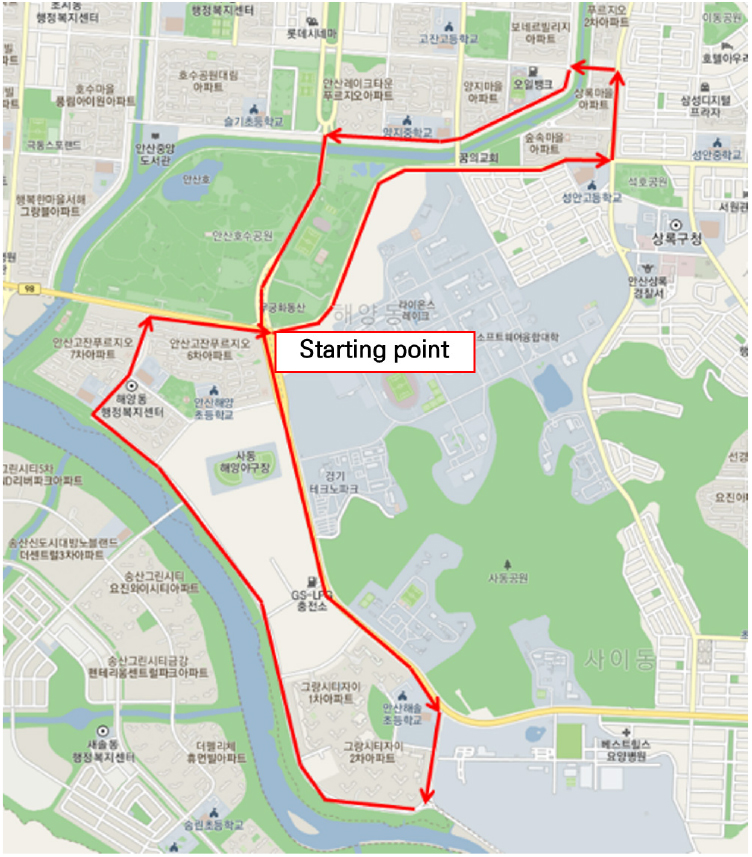

선행 과정에서 구현된 알고리즘을 학습시키기 위하여 경기도 안산시 해양동 일원을 중심으로 블랙박스 영상을 촬영하고 적용하는 과정을 진행하였다. 실험 구간은 Figure 5와 같이 총 10.3km 구간을 설정하였다. 해당 구간은 왕복 4-8차로로 구성되어 있으며, 연속류의 특성을 지니는 해안로 호수공원사거리-해솔초등학교 구간, 용신로 사리사거리-안산8교사거리 구간과 도시부도로의 특성을 보이는 용신로, 항가울로, 안산천남로, 해양1로 구간을 포함한다. 또한, 해솔초등학교‧중학교 앞은 왕복 8차로, 청석초등학교 앞은 왕복 6차로, 양지초등학교 앞은 왕복 4차로 구간의 어린이 보호구역이 지정되어 있다. 또한, 실험 구간 내 차선은 본선 구간에서 실선 4m와 공백 4m로 구성되어 있다. 실험용 영상에 사용된 선행 차량은 셀토스로, 전폭 1800mm, 전고 1600mm의 크기를 가진다. 후행 차량에서 촬영된 블랙박스는 30fps로 156도를 2560*1440의 WQHD(Wide Quad High Definition) 해상도로 촬영할 수 있는 모델로, 바닥 기준 120cm 지점, 차량 전방 기준 190cm 지점에 6.3도 상향된 각도로 설치하였으며, Figure 6의 화면과 같이 전방 주행영상이 촬영되게 하였다.

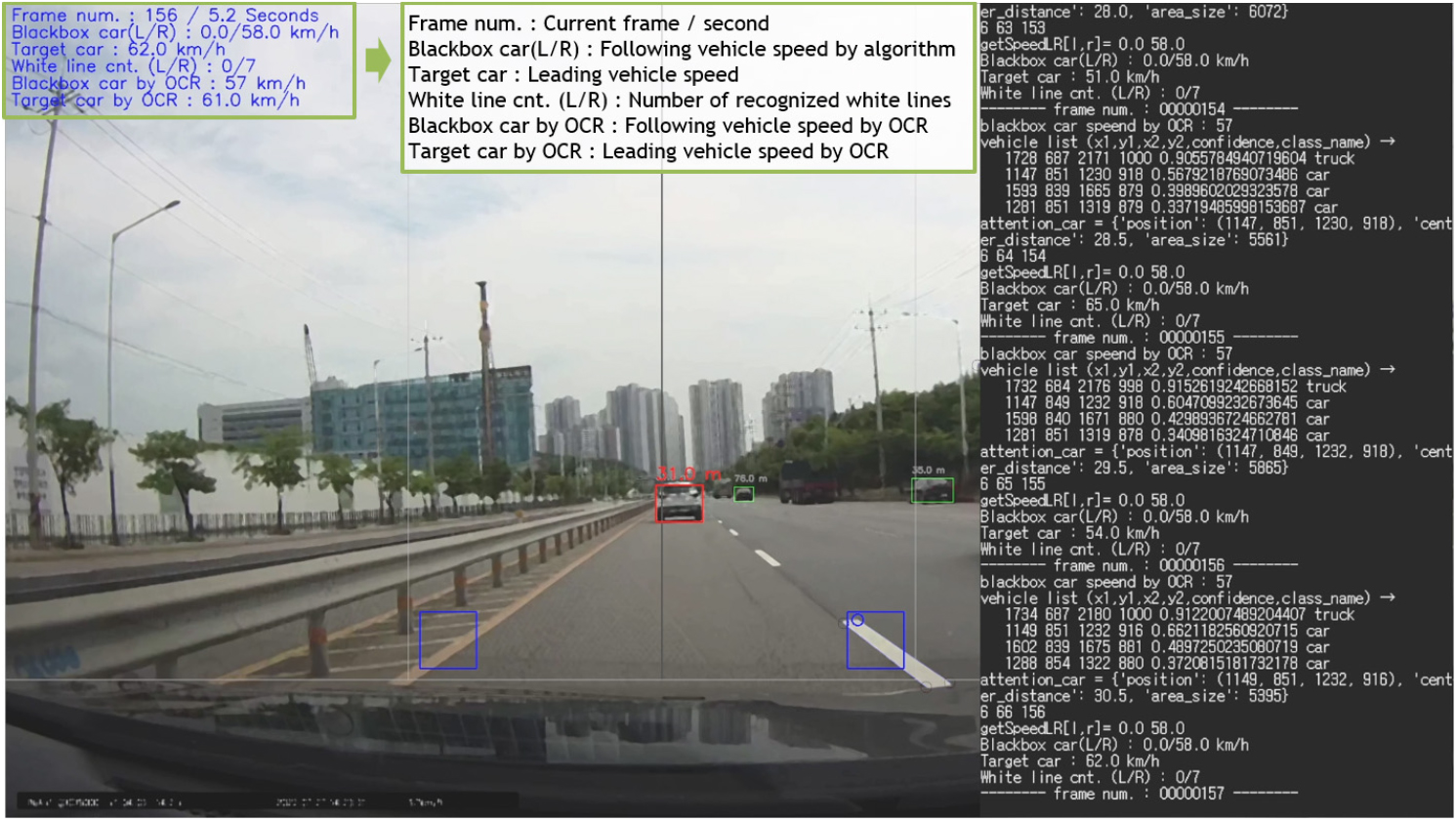

영상 인식 알고리즘 적용을 위한 기준값 설정을 위하여 주행 전 선행 차량과 후행 차량의 거리를 5m 단위로 증가시키면서 사전 촬영을 하여 카메라의 초점 거리 및 거리별 이미지상의 픽셀값 변화량을 도출하였으며, 이 과정을 통하여 실증구간과 실제 분석 구간이 다를 경우에도 사전에 차선 도색 길이 값을 입력해줌으로써 알고리즘 상에서 정상적으로 분석이 가능하도록 하였다. Figure 5에 제시된 구간을 주행하여 주행 데이터를 수집하였다. 수집된 데이터는 선행 개발된 알고리즘이 적용된 프로그램을 통해 Figure 7와 같은 형태로 분석이 수행되었다. 분석 화면의 좌측 상단에는 블랙박스 영상 재생시간 및 프레임, 인식된 좌우 차선의 개수 및 차선 개수에 기반한 선행 및 후행 차량의 추정 속도, OCR 판독에 기반한 차량 속도가 표출된다. 화면 중앙은 블랙박스 영상화면이 표출되며 선행 차량 인식을 위한 세로 중심선 및 차선 인식의 정확도를 높이기 위하여 대시보드 부분을 인식하지 않도록 설정하는 가로 중심선이 설정되어 있다. 해당 화면에서 선행 차량은 빨간색 사각형 객체로 표기되며, 인식된 차선은 파란색 사각형 객체 및 원형 객체로 표기된다. 화면 우측은 알고리즘이 작동되고 좌측 상단에 출력되는 결과 값이 프레임 단위로 저장되는 과정이 수행된다.

그리고 알고리즘을 통해 추정한 차량 속도의 정확도를 판단하기 위하여 선행 및 후행 차량에 GPS 장치를 설치하여 1초 단위 위도, 경도, 고도, 시각, 속도, 방위각 데이터를 수집하여 알고리즘을 통해 산출된 추정 속도와의 비교 분석을 수행하였다. 비교 분석을 위하여 평균 절대 오차(Mean Absolute Error)와 평균 제곱근 오차(Root Mean Square Error, RMSE)를 사용하였다. MAE는 실제 정답 값과 예측 값의 차이를 절댓값으로 변환한 뒤 합산하여 평균을 구하는 것으로, 특이값이 많은 경우에 주로 사용되며 값이 낮을수록 좋은 특성을 보인다. MAE의 장점은 직관적이며 실제 값, 예측 값과 같은 단위를 가진다는 점이며, 단점으로는 실제 정답보다 높게 예측했는지, 낮게 예측했는지 알기 어렵고 스케일에 의존하는 특성을 지닌다. MAE의 산출식은 Equation 1과 같다.

RMSE는 평균 제곱 오차(Mean Squared Error, MSE)에 제곱근을 취한 형태로, MSE가 가지는 단점인 1 이상의 오차가 날 경우 에러 값이 급격히 커지는 문제를 감소시킬 수 있는 장점을 지닌다. RMSE의 산출식은 Equation 2와 같다.

속도의 실제 값과 추정 값을 비교하여 정확도에 대한 분석을 수행한 결과, 직선 구간에서의 MAE는 10.1 RMSE는 13.2로 나타나고 실제 주행 시의 속도 변화 패턴과 동일한 결과를 보여준 반면, 곡선 구간 및 차선 인식률이 저하되는 구간에서는 Table 2에 제시된 것과 같이 MAE와 RMSE 값이 약 2배 수준으로 크게 증가하고, 주행 중 속도 변화 패턴과 다른 형태의 패턴을 보여주는 것으로 나타났다. 직선 구간과 곡선 구간에서의 MAE와 RMSE 값의 차이가 발생하는 것은 영상인식 알고리즘에서 직선에 기반하여 차선을 추출하는 과정을 거쳤기 때문에 곡선 구간에서 왜곡이 발생하고 그에 따라 정확도가 감소하는 것으로 판단된다. 또한, 차선 길이 변화 및 도색, 실선 여부에 따라서도 정확도가 변화하는 것으로 나타났다. 차선이 실선으로 변경되는 구간의 경우 끝점 인식이 불가능해짐에 따라 속도 예측이 불가능한 문제점이 존재한다. 또한, 차선 인식이 불가능한 교차로 내, 노면표시 및 노면 색상이 변경되는 어린이 보호구역 등의 구간에서도 차선의 시작점 및 끝점의 인식률 저하로 인하여 속도 예측의 정확도가 감소하는 것으로 나타났다. 따라서 본 연구에서는 정확도가 확보된 직선 구간 및 노면표시의 영향이 적은 도로 구간에서 발생한 후미추돌 교통사고에 대해서 분석을 수행하였다.

Table 2.

Comparison of accuracy for speed prediction by alignment

| Alignment | MAE | RMSE |

| Straight | 10.1 | 13.2 |

| Curve | 22.5 | 27.1 |

선행 과정에서 학습된 알고리즘을 활용하여 고속도로 본선 구간의 동일 차로에서 발생한 후미추돌 유형의 교통사고 12건에 대한 분석을 수행하였다. 각 교통사고 블랙박스 영상은 사고 발생 5-13초 전 상황부터 알고리즘을 통하여 선행 차량 및 후행 차량의 속도, 차간거리를 도출하고, 도출된 값을 이용하여 TTC까지 추출하였다.

TTC(Time to Collision)는 1971년 미국 Hayward에 의해 처음으로 정의된 개념으로, 현재의 속도 및 경로가 유지될 경우, 충돌이 발생하기까지의 시간을 나타내는 가장 대표적인 대리안전지표이다. TTC를 계산하는 방법은 아래 Equation 3과 같다.

여기서 는 선두차량의 위치, 는 목적 차량의 위치, 는 선두차량의 속도, 는 목적 차량의 속도, 는 차량 길이를 나타낸다. TTC를 정의하기 위해서는 차량추종 이벤트 상황에서 선행 차량보다 후행 차량의 속도가 더 빠르고, 차로변경이 없어야 하는 가정이 존재한다. 정의상 TTC 값이 클수록 안전한 상태라고 볼 수 있으며, FHWA 등에서는 TTC 값이 1.5초 미만인 경우를 위험한 상황으로 정의하고 있다.

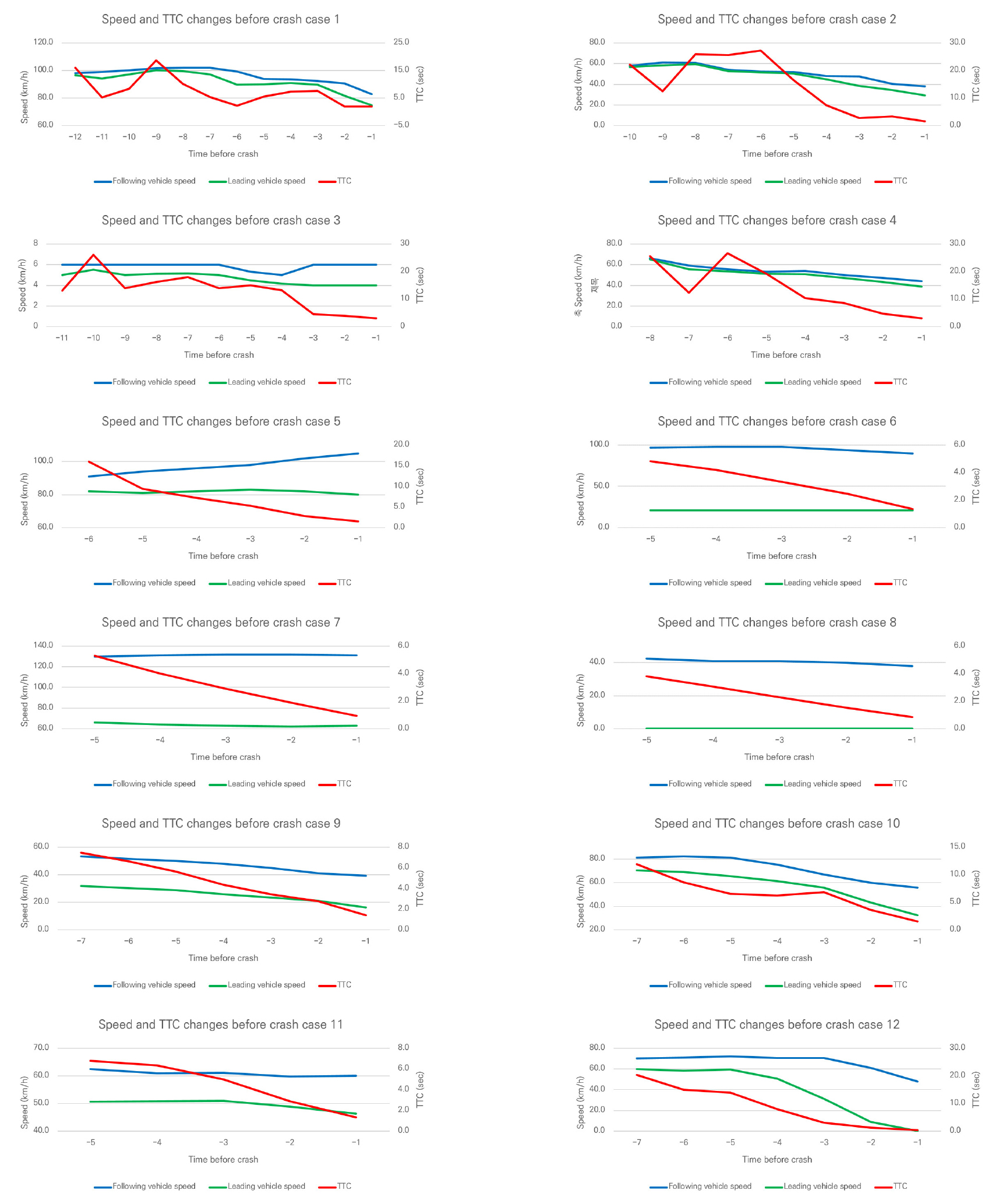

각 교통사고에 대한 설명은 Table 3에 제시하였으며, 개별 사고 직전 속도 및 TTC 그래프는 Figure 8과 같다. 또한, 사고 발생 교통상황에 따라 후행 차량의 속도를 기준으로 소통 원활, 서행, 정체의 3가지 그룹으로 분류하였다. 한국도로공사의 고속도로 교통정보 분류 기준에 따라 소통 원활은 시속 80km/h 이상, 서행은 시속 40km/h 이상 80km/h 미만, 정체는 시속 40km/h 미만으로 설정하였다. 그리고 각 속도 그룹별 사고 발생 5초 전부터 1초 전까지의 후행 차량 속도, 선행 차량 속도, TTC에 대한 분석을 수행하였다.

Table 3.

List of each crashes

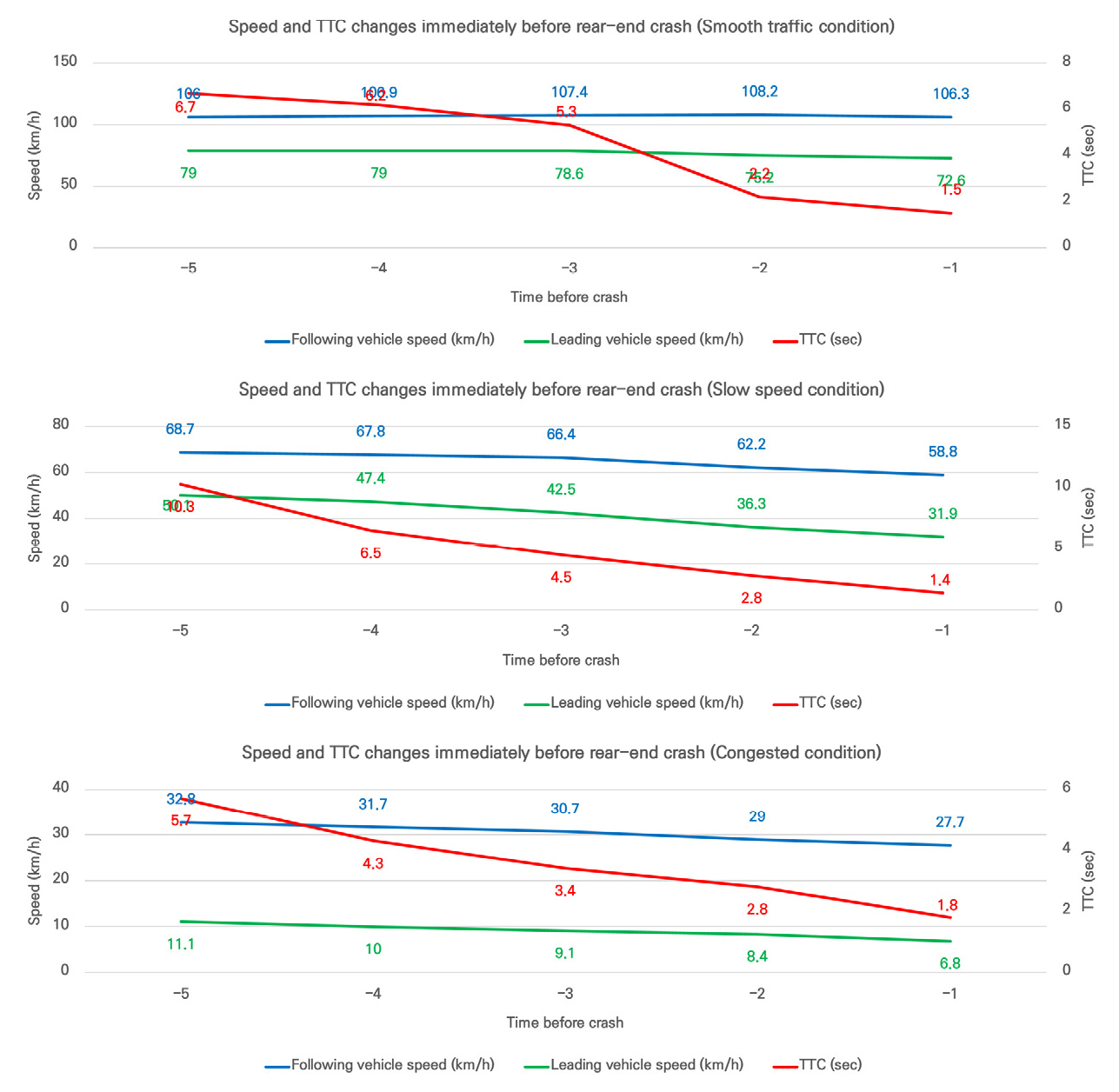

소통이 원활한 상황에서 발생한 후미추돌의 경우 후행 차량의 평균 속도가 106-108km/h를 유지하는 것으로 나타난 반면, 선행 차량의 속도는 사고 발생 5초 전 79km/h에서 1초 전 72.6km/h로 감소하는 것으로 나타났다. 이에 따라 TTC도 사고 발생 5초 전에는 6.7초였으나 사고 발생 2초 전 2.2초로 급격히 감소하는 것으로 나타났다. 이러한 패턴은 주로 고속으로 주행 중 전방의 교통정체 등의 요인이 발생하였을 때 선행 차량은 감속을 시작하였으나, 선행 차량이 이를 늦게 인지하여 후미추돌이 발생하는 경우로 볼 수 있다. 또한, case 5의 사례와 같이 야간시간대 주시태만으로 인하여 전방 차량을 인지하지 못하고 계속 가속을 하여 후미추돌이 발생하는 사례도 존재하였다.

서행 상황에서 발생한 후미추돌의 경우 후행 차량의 평균속도가 사고 발생 5초 전 68.7km/h에서 사고 발생 1초 전 58.8km/h로 9.9km/h 감소하는 것으로 나타났으나, 선행 차량의 경우 5초 전 50.1km/h에서 1초 전 31.9km/h로 18.2km/h 감소하여 결국 후미추돌이 발생하는 것으로 나타났다. TTC 또한 사고 발생 5초 전 10.3초였으나 사고 발생 1초 전에는 1.4초까지 감소하였다. 소통이 원활한 상황과 비슷하게 전방의 교통정체를 인지한 선행 차량의 감속도가 후행 차량에 비해 높은 값을 보이고 이에 따라 후미추돌이 발생하는 것으로 풀이된다. 하지만 소통 원활 상황에서 발생한 사고의 경우 후행 차량이 감속을 하지 못한 반면, 서행 상황에서는 후행 차량도 감속을 하였으나 추돌이 발생하였다는 행태의 차이점이 존재하였다.

정체 상황에서 발생한 후미추돌의 경우 후행 차량의 평균속도가 사고 발생 5초 전 32.8km/h에서 사고 발생 1초 전에 27.7km/h로 감소한 반면, 선행 차량의 평균속도는 사고 발생 5초 전 11.1km/h, 1초 전에는 6.8km/h로 사실 상 정지 수준의 거동행태를 보이는 것으로 나타났다. 이러한 특성으로 인하여 원활 및 서행 상황과는 다른 패턴의 TTC 값이 도출되었다. TTC의 경우 사고 발생 5초 전 5.7초에서 사고 발생 1초 전 1.8초의 값이 도출되었으며, 급격하게 TTC가 감소하는 구간 없이 일정한 기울기를 보인다. 이는 선행 차량의 거동이 급감속이 없고 정지상태에 근접하였기 때문에 나타나는 것으로 풀이된다. 각 속도 그룹별 속도 및 TTC 변화에 대해 Table 4 및 Figure 9에 나타내었다.

Table 4.

List of changes in speed and TTC by speed group

결론 및 향후 과제

본 연구에서는 블랙박스 영상인식 알고리즘을 개발하고, 이를 통하여 실제 후미추돌 교통사고 발생 직전의 선행 차량 및 후행 차량의 주행행태를 확인하였다. OpenCV의 YOLO5에 기반한 영상 인식 알고리즘을 개발하여 블랙박스의 교통사고 영상을 전처리 하였으며, 후행 차량 속도 예측, 선행-후행 차량 거리 예측, 선행 차량 속도 예측의 3단계 모듈로 구성된 차량 속도 및 거리 예측 알고리즘을 개발하여 선행 및 후행 차량의 속도 및 차간 거리, TTC를 도출하였다. 개발된 알고리즘 학습을 위하여 실제 도로에서의 주행 영상을 이용하였으며, 학습된 알고리즘을 실제 고속도로에서 발생한 후미추돌 사고 12건의 블랙박스 영상에 적용하여 사고 발생 직전 차량 주행속도에 기반한 그룹별 차량의 주행행태를 확인하였다. 분석 결과, 각 속도그룹별 후미추돌의 발생 상황이 조금씩 다른 점을 확인하였다. 교통상황이 소통 원활일 때 발생한 후미추돌사고의 경우, 전방의 교통정체 등 환경이 악화된 상황에서 선행 차량만이 이를 인지하고, 후행 차량은 인지하지 못하여 사고가 발생한 경우가 많은 것으로 나타났으며, TTC 값에서도 사고 발생 3초 전 5.3초에서 발생 2초 전에 2.2초로 급감하는 특성이 나타났다. 이는 평균 주행속도가 80km/h 이상인 소통 원활 상황에서 급격한 변화가 있을 때 운전자의 대응하기 위해서 충분한 시간이 확보되어야 하나, 본 연구에서 활용한 사고자료의 경우 고속주행으로 인해 운전자가 급감속 등 대응을 했음에도 불구하고 속도 차이로 인한 추돌이 발생하는 양상을 보여주었다. 반면, 서행 상황에서 발생한 후미추돌사고의 경우 전방의 교통상황을 선행 차량과 후행 차량이 모두 인지하였으나, 후행 차량이 선행 차량보다 낮은 감속도를 보여 후미추돌 사고가 발생한 것으로 풀이된다. 마지막으로 정체상황에서 발생한 후미추돌사고의 경우 선행 차량이 정지한 상황에서 후행 차량이 추돌하는 패턴을 보여주었다. 서행 및 정체 상황에서 발생한 사고의 경우 후행 차량 운전자의 전방 주시 태만 등이 사고에 영향을 미치는 것으로 나타났으며, 일부 사고 사례의 경우 선행 차량과 후행 차량의 속도 차가 80km/h에 달하는 등 극심한 차이를 보여 제동만으로는 사고를 회피할 수 없는 것으로 판단되었다.

이 연구를 통해 블랙박스 영상에 기반한 교통안전성 평가 방법론이 더욱 발전할 수 있을 것으로 기대한다. 하지만, 본 연구를 통해서 몇 가지 보완사항이 존재하였다. 첫 번째는 주행 영상에 다양한 방해 요인이 있는 경우에 정확도가 낮아지는 현상이 관측되었다. 특히 흰색 차선의 인식에 방해가 되는 흰색 실선의 훼손, 곡선부 구간, 어린이보호구역 등 구역 표시로 인한 포장 색의 변화 및 글자 표기, 교차로 내부 등 차선이 없는 구간, 차로변경금지 등 실선이 연속되는 구간, 흰색 차선이 차선 길이가 바뀌는 구간, 포장 파손 등이 존재하면 정확도가 낮아지는 문제점이 있어, 흰색 실선의 인식률을 향상시키는 연구 또는 흰색 차선이 아닌 다른 매개체를 인식하여 속도를 추정하는 알고리즘 개발 등의 추가적인 방안이 필요할 것으로 보인다. 흰색 차선의 인식 정확도 향상을 위해서는 허프변환 및 직선 추출 단계에서의 정확도를 높여 차선이 있는 영역을 정확하게 판단하고, 차선 영역의 곡선 변환도 가능하도록 고도화하는 것이 필요하다. 두 번째는 분석 영상의 해상도에 따라 결과가 상이하게 나타나는 점이다. 알고리즘 학습 시 사용한 영상의 해상도는 2560*1440의 WQHD(Wide Quad High Definition) 규격이었으나, 실제 사고주행 12건의 영상 해상도 수준은 이보다 낮은 1280*720의 HD 수준이거나 이보다 더 낮은 규격이었다. 이러한 화면 해상도의 저하로 인한 정확도 하락 등의 문제가 발생하였으며 이 점에 대한 보완이 필요하다. 마지막으로 본 연구에서는 대리안전지표 중 TTC만을 산출하였으나, 기존의 많은 연구에서는 TET(Time Exposed Time to collision), TIT(Time Integrated Time-to-collision indicator), DRAC(Deceleration Rate to Avoid a Collision) 등의 다양한 지표를 활용하여 교통 안전성을 평가하였다. 다양한 지표를 활용하여 사고 발생 직전 상황에 대한 분석을 수행한다면 TTC로는 확인 불가능한 위험도를 파악하는 데 도움이 될 것이며 블랙박스 영상기반 안전성평가의 활용도도 증대될 것으로 기대한다. 마지막으로 본 연구에서는 직선 구간, 차선 도색의 인식이 잘 되는 구간, 같은 차로 상에서 발생한 후미추돌사고의 조건을 모두 만족하는 교통사고의 영상에 대해 분석을 수행하여 12건의 교통사고를 분석하여 통계적 유의성을 확보하는 것이 어려웠다. 향후에는 최소 30건 이상의 교통사고 블랙박스 영상을 확보하여 분석을 수행함으로써 통계 분석 및 통계적 유의성 판단 등 다양한 분석을 활용할 수 있을 뿐 아니라 교통사고 모형 개발 등을 통한 심층적인 연구를 수행할 수 있을 것으로 보인다. 이러한 한계점들을 보완하여 추가적인 연구를 수행한다면 블랙박스 영상을 이용한 사고 분석에 활용을 할 수 있을 뿐 아니라 추후 카메라를 활용한 비전 센서를 이용하는 자율주행차 등에서 후미추돌 사고 회피 및 대응을 위한 기초자료로 활용할 수 있을 것으로 기대한다.