서론

연구 방법

1. 데이터 설명

2. YOLO 기반의 차량 탐지 및 좌표 추출

3. 영상처리 기법을 활용한 Traffic Context 추출

4. Transformer 기반의 차로 변경 예측 모델

실험 결과

1. 평가 지표

2. 검출 모델 성능 평가

3. 차로 변경 예측 모델 성능 평가

결론 및 고찰

서론

차로 변경은 도로 상에서 가장 위험한 기동 중 하나로 꼽힌다. 차로 변경은 전체 도로 사고의 9%를 차지하며(Yang et al., 2018), 미국에서 매년 약 24만에서 61만 건의 차로 변경 관련 충돌 사고가 발생한다(Zhao et al., 2016). 차로 변경 행동은 다른 차선 차량과의 간섭으로 인해 차량의 안전에 지대한 영향을 미치며, 특히 고속으로 주행하는 교통 흐름에서 더욱 심각한 사고의 위험이 있다(Chen et al., 2020). 이러한 위험성은 운전자의 판단 미스, 예측 가능성의 부족, 혹은 주변 차량과의 의사소통 실패 등 다양한 요인에 의해 발생할 수 있다(Shawky, 2020). 또한, 차량의 효율적인 차로 변경은 교통 정체를 줄이고 도로의 통행 능력을 높이는 등 도로교통 시스템의 안전성 및 효율성 측면에서 중요한 요소 중 하나이다. 최근 자율주행 분야에서도 주변 차량의 차로 변경 인식 및 예측과 같은 주변 차량의 행동 인식 및 예측 연구가 활발히 이루어지고 있기에, 이러한 맥락에서, 차량의 차로 변경을 인식하고 예측하는 연구는 매우 중요하다(Jeong et al., 2021; Lee and Kim, 2023).

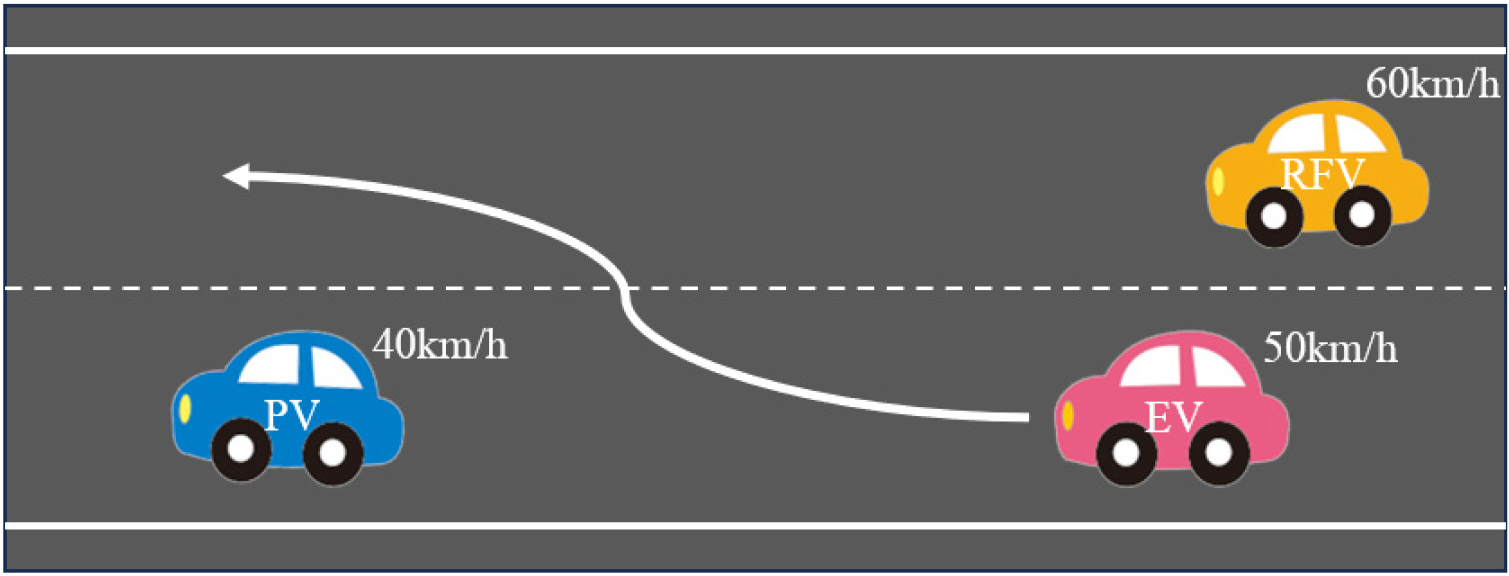

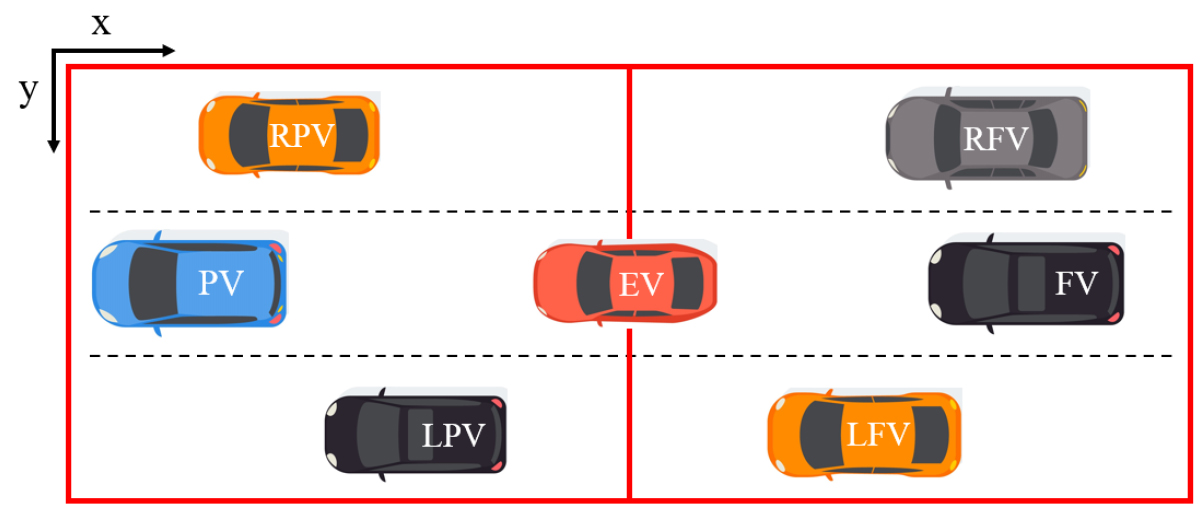

이와 같은 차로 변경의 예측은 차로 변경 차량(Ego Vehicle, EV)과 주변 차량(동일 차선의 선행 차량(Preceding Vehicle, PV) 및 후방 차량(Following Vehicle, FV))의 움직임 등과 같은 교통 맥락(Traffic Context)의 이해를 통해 예측할 수 있다(Mozaffari et al., 2022; Wissing et al., 2017; Xue et al., 2022). Figure 1은 차로 변경 움직임에 대한 교통 맥락의 예를 나타낸다. EV는 PV와의 차간 거리(Headway) 감소로 인해 차로 변경을 시도하고, 이때 오른쪽 후방 차량(Right Following Vehicle, RFV)과의 충분한 공간을 확보하기 위해 순간적으로 가속하거나, RFV가 EV의 방향지시등 또는 전방 교통 맥락 파악을 통해 EV에 대한 차로 변경을 예측하고 서서히 감속을 시도한다. 이와 같이 전반적인 교통 맥락 이해를 통해 EV의 차로 변경 기동을 예측할 수 있다.

차로 변경 예측에 관한 기존 연구의 접근 방식을 살펴보면, 다양한 센서로부터 차량을 탐지하고, 그 궤적을 예측하는 연구들이 국내·외적으로 활발히 진행되어왔다(Song and Li, 2021; Kim and Han, 2020; Patel et al., 2018; Lee et al., 2023; Yuan et al., 2023). 차로 변경 예측 연구는 크게 1) EV 관점에서 주변 교통 맥락 인식과 2) top-view에서 전반적인 교통 맥락 인식으로 분류할 수 있다. 먼저, EV의 관점에서 주변 교통 맥락을 인식하는 연구를 살펴보면, Kim and Han(2020)은 레이더와 카메라 센서를 활용하여 주변 환경을 인식하고, 선형 칼만 필터를 적용한 측면 및 후방 차량의 경로를 예측함으로써 안전한 차로 변경 가능 여부를 판단하였다. 또 다른 예로써, Patel et al.(2018)은 라이다 센서 데이터를 포함한 실제 고속도로 주행 데이터를 기반으로, 선형 구조적 순환 신경망(SRNN)을 적용하여 인접 차량의 경로를 예측하는 연구를 수행하였다. 이러한 레이더나 라이다와 같은 센서를 사용하는 방식은 차량이나 도로 구조물 등의 요인들에 따라 측정이 방해되거나 센서가 오작동하는 문제를 포함하기에, 드론 등과 같은 탑 뷰에서의 영상 정보를 활용한 연구 또한 일부 진행되었다(Lee et al., 2023; Yuan et al., 2023). Lee et al.(2023)은 드론 시점의 영상을 활용하여 객체 검출 모델 중 하나인 You Only Look Once version 7 (YOLOv7) 모델을 활용하여 회전 교차로에서 차량을 식별하고 이를 추적하는 시스템을 제안하였다. 제안하는 시스템은 실시간으로 차량의 진입 속도를 측정하고 다양한 교통 상황에서의 차량 행동을 분석할 수 있다. 또한, Yuan et al.(2023)은 드론을 통해 수집된 차량 궤적 데이터인 CitySim(Zheng et al., 2022)을 활용하여 차로 변경 의도와 차량 상태를 예측하는 통합 모델을 개발하였다. 이러한 접근 방식은 장애물 없이 차량을 직접적으로 확인할 수 있으며, 전체적인 교통 흐름을 보다 정확하게 파악할 수 있다는 장점이 있다. 또한, 영상 전반의 개별 차량에 대해 궤적 형태로 가공할 수 있으며 차량 주행 행태에 대한 분석이 가능하다(Ko et al., 2021).

본 연구에서는 드론으로부터 획득한 탑 뷰의 영상 정보를 활용하여 도로의 차량들을 인식하고, 교통 맥락을 파악하여 차량의 차로 변경을 예측하는 방법을 제안한다. 제안하는 방법은 크게 차량 탐지 및 궤적 산출, 교통 맥락 추출, 차로 변경 예측의 세 부분으로 나뉜다. 먼저 차량 탐지 및 궤적 산출 부분에서는 컴퓨터 비전 분야에서 뛰어난 성능을 보이는 YOLOv8(YOLOv8, 2023) 모델을 활용하여, 도로 상의 차량을 인식하고, 차량의 좌표정보 및 그 궤적을 수집한다. 다음으로, 영상 처리 기법을 활용하여 도로, 교통 등 주행과 관련된 다양한 상황과 환경적 요소를 의미하는 “교통 맥락(Traffic Context)” 정보를 추출하고, 차로 변경 예측을 위한 트랜스포머(transformer) (Vaswani et al., 2017) 기반 인공지능 모델을 구축한다. 본 연구의 핵심은 추출된 교통 맥락의 중요한 부분에 선택적으로 집중함으로써 복잡한 교통 흐름과 차량 간의 상호작용을 이해하여 차로 변경을 예측한다는 것이다.

본 연구에서 제안하는 컴퓨터 비전 기반의 교통 맥락 추출 기법과 추출된 교통 맥락에서 차로 변경에 영향을 미치는 세부 정보를 파악하여 차로 변경을 예측하는 모델을 통해, 센서 기반 접근법의 한계를 극복하며 복잡한 교통 상황에 대한 정밀한 분석으로 정확하고 신뢰할 수 있는 차로 변경 예측 모델을 개발하는 것에 그 의의가 있다.

연구 방법

1. 데이터 설명

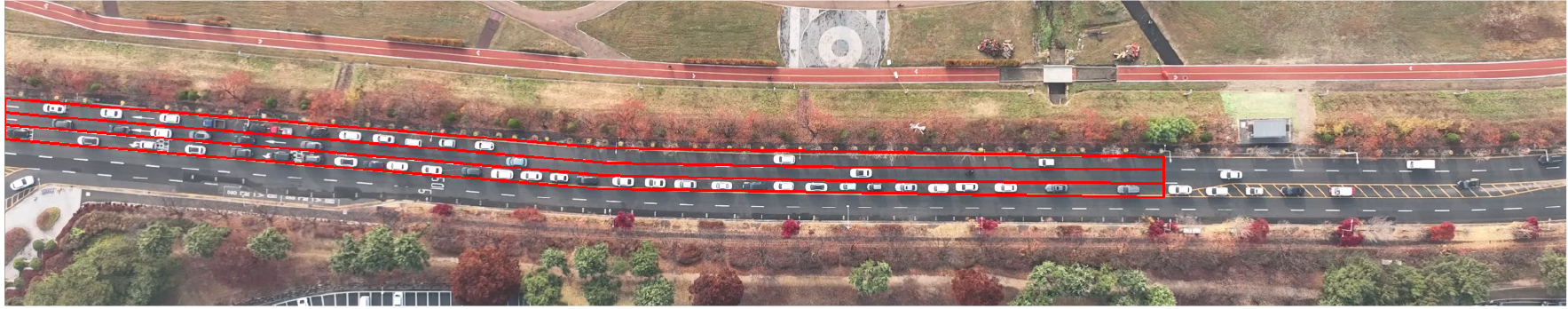

본 연구에서는 드론으로부터 획득한 도심 지역의 차량 주행 영상을 활용한다. 촬영에 활용된 드론 기종은 DJI Mavic 3 Pro이며, 대전 유성구 구성동 445-1 일대의 도로와 차량을 약 250m 고도에서 약 330m 범위로 촬영하였다. 상행 차선은 2차로에서 3차로로 증가하는 형태이며 하행 차선은 3차로에서 2차로로 감소하는 형태로 구성되어 있다. 영상은 2022년 11월 16일 오전 7시 30분부터 오전 8시, 오전 8시 10분부터 오전 8시 40분, 오전 8시 50분부터 오전 9시 20분까지, 각각 30분간 세 차례에 걸쳐서 촬영되었다. 수집된 영상의 해상도는 1920*1080이며, 수집 단위는 30 frame per second(FPS)이다. 본 연구의 실험에서는 영상 내 차로 변경 움직임을 포함하는 영상 클립(clip)을 약 110개 추출하였고, 각 클립은 차로 변경하는 순간을 중심으로 ±5초씩 구성되며, 하나의 클립 당 약 10초의 길이를 갖는다. Figure 2는 본 연구에서 사용된 영상 클립의 예시를 나타낸다.

2. YOLO 기반의 차량 탐지 및 좌표 추출

본 절에서는 본 연구에서 객체 검출을 위해 활용된 YOLOv8 모델과 객체 검출 결과로부터 차량의 좌표정보를 추출하는 방법에 관하여 설명한다. YOLOv8 모델은 YOLO 계열의 영상 내 객체 탐지(Object detection)에 널리 활용되는 딥러닝 기반의 알고리즘 중 하나이며, YOLOv1(Redmon et al., 2016)부터 발전해오며 그 성능을 입증해왔다. 특히, 본 연구에서 해결하고자 하는 드론 기반의 탑 뷰 영상 정보에서 미세하게 움직이는 차량의 탐지 문제를 해결하기에 매우 적합하다고 볼 수 있다(Jiang et al., 2022).

본 연구에서 YOLOv8 모델을 활용한 차량 정보 추출 과정은 크게 차량 탐지를 위한 모델 학습과 RoI(Region of Interest)에 따른 차량 탐지, 각 차량의 속도 및 가속도 추출로 구성된다. 먼저, 영상 내 나타난 도로 위 차량들의 라벨링 과정을 거치고, 이를 바탕으로 모델을 학습시킨다. 영상 클립마다 RoI를 지정하고 학습된 YOLOv8을 바탕으로 객체 탐지를 진행한다. 이를 통해 각 차량 간의 프레임 별 위치에 대한 좌표와 해당 차선 위치 등에 대한 특징을 추출하고, 추출된 좌표를 바탕으로 차량의 종·횡 방향 속도, 가속도를 계산한다.

1) 차량 탐지를 위한 YOLOv8 모델 학습

먼저, 본 연구에서 활용한 YOLOv8 모델의 차량 객체 학습을 위해 라벨링을 진행하며, 라벨링 도구로는 labelImg(LabelImg, 2015)을 사용한다. 일반적으로 YOLOv8 모델은 Common Objects in Context 데이터 셋(Lin et al., 2014)을 활용하여 사전 학습(Pre-trained)되어 있지만, 본 연구의 인식 대상인 “매우 작은 크기의 탑 뷰에서의 차량”은 학습되어 있지 않기에, 추가적으로 학습을 진행한다. 또한, 사전 학습된 YOLOv8 모델은 도로 색상과 유사한 검은색 차량을 제대로 탐지하지 못하는 문제점이 존재하여 검은색 차량의 탐지 성능을 높이기 위해 차량을 색상별로 구분 지어 추가 학습한다. 학습은 전체 영상에서 약 8,500장의 이미지 프레임(Frame)을 추출하고, 차량 약 57,000대에 대해 차량 색상에 따른 라벨링을 진행하였다. 영상 클립 내에서 출현 빈도가 낮은 트럭과 버스, 사람이 식별하기 어려울 정도의 작은 크기의 물체인 오토바이 등은 라벨링 대상에서 제외하였다. 학습 데이터, 검증 데이터, 테스트 데이터 비율을 8:1:1로 설정(Liu et al., 2023)하여 학습을 진행하였으며, Grid Search 기법을 통해 설정된 하이퍼파라미터(Hyper-parameters)는 Table 1과 같다.

Table 1.

Detection model hyperparameters setting

| Hyper-parameters | Values |

| Initial learning rate | 0.01 |

| Optimizer | AdamW |

| Momentum | 0.937 |

| Epoch | 500 |

| Image size | 1920 × 1080 |

| Patience | 30 |

| Batch size | 4 |

2) RoI 설정 및 차량 탐지

다음으로, 영상 내에서 차량 객체를 인식할 부분인 관심 영역(Region of Interests, RoI)을 설정하고, 관심 영역 내의 차량만을 탐지한다. 본 연구에서 드론 촬영을 진행한 시점인 오전 시간대에 교통량이 많고, 차로 변경이 자주 발생하는 상행 차선을 관심 영역으로 설정하였다. 또한, 차선별로 세부적인 RoI를 적용하여 특정 차량의 차선 정보 및 차로 변경 기동을 파악할 수 있도록 한다. 관심 영역으로 설정한 상행 차선의 총 분석구간 길이는 약 280m이며, Figure 3은 RoI가 적용된 영상 클립에 대한 이미지 클립 예시를 나타낸다.

본 연구에서는 다중 객체 추적(Multi-Object Tracking)을 위해 Byte Tracker(Zhang et al., 2022)알고리즘을 사용한다. Byte Tracker는 탐지된 객체의 궤적을 유지하여 연속된 프레임에서 동일 차량을 정확하게 추적할 수 있으며, 빠른 연산 속도와 높은 정확도를 제공하기 때문에 다양한 교통 상황에서 차량을 추적하기에 적합하다. Figure 4는 추가 학습된 YOLOv8 모델을 활용하여 RoI 내 차량을 탐지한 결과 중 일부이다.

3) 개별 차량의 종·횡 방향 속도 및 가속도 측정 방법

본 세부 절에서는 이전 세부 절에서 인식한 차량 정보로부터 차량의 좌표, 종·횡 방향 속도 및 가속도를 계산 방법에 대하여 설명한다. 종·횡 방향 속도 및 가속도 계산에 앞서 도로의 굴곡에 따른 차량의 종·횡 방향 속도 및 가속도의 차이가 존재하지만, 해당 도로의 곡률이 크지 않아 본 연구에서는 수식에 추가적인 곡률을 적용하지 않았으며 실험에 활용한 도로를 직선 도로로 가정하고 실험을 진행하였다.

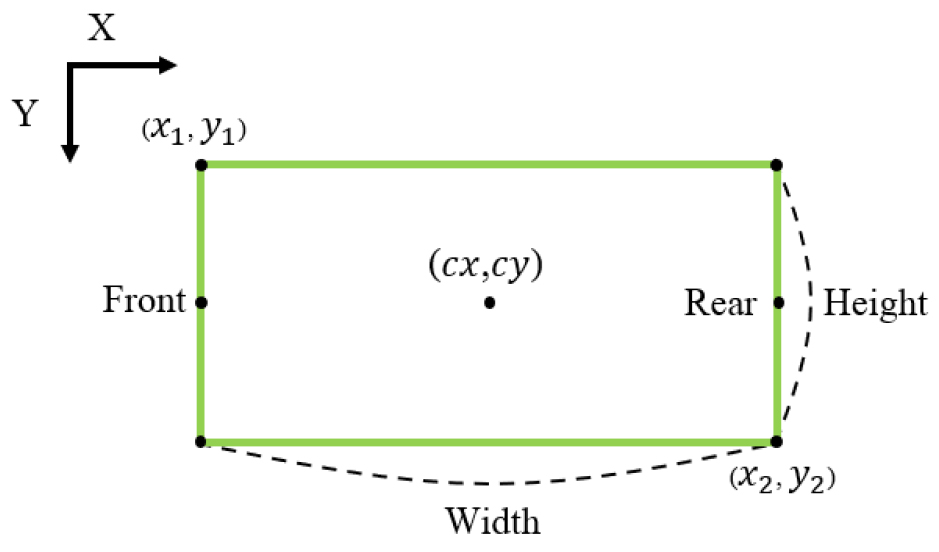

Figure 5는 YOLOv8 모델로부터 획득한 차량의 bounding box에서 알 수 있는 좌표 정보를 나타낸다. 일반적으로 객체의 bounding box는 좌상단(Top-left)과 우하단(Bottom-right)의 좌표 (각각 (, ), (, ))인 xyxy 좌표체계 또는 중심(Center)좌표 ((, ))와 너비(Width) 및 높이(Height)로 구성된 cxcywh 좌표체계로 구성된다. YOLO 계열의 모델에서는 cxcywh 좌표체계를 채택하고 있다.

Equation 1과 2는 cxcywh 좌표계를 xyxy 좌표계로 변환하는 방법에 관한 것이다.

본 연구에서는 Equation 3과 4를 활용하여 차량의 전방 및 후방 좌표를 계산한다.

다음으로, Equation 5를 활용하여 차량의 속도를 추출한다. 는 시점일 때 차량의 좌표이며, 은 시점에서 한 프레임 다음 시점의 차량의 좌표이다. 는 1/30로 30 FPS 영상에서의 한 프레임의 시간 간격을 의미한다. 은 도로의 실측 정보를 통하여 획득한 픽셀 크기 값(m/pixel)으로 속도를 m/s로 변환할 수 있다. 횡 방향 속도를 구하는 방식도 동일하다.

마지막으로, 차량의 가속도는 Equation 6과 같이 추출된 차량의 속도를 미분하여 계산한다. Equation 6은 종 방향 가속도를 구하는 식에 대해 나타낸 것이며, 횡 방향 가속도도 동일하게 계산할 수 있다. 는 시점일 때 차량의 종 방향 속도이며, 은 시점에서 한 프레임 다음 시점의 차량의 종 방향 속도이다. 마찬가지로, 는 1/30로 30 FPS 영상에서의 한 프레임의 시간 간격을 의미한다.

3. 영상처리 기법을 활용한 Traffic Context 추출

Traffic Context는 도로, 교통, 또는 이동성과 관련된 다양한 상황과 환경적 요소를 포괄하는 개념으로써, 컴퓨터 비전 분야에서 이미지나 비디오 내의 객체 및 환경정보와의 관계를 설명하여 이미지/비디오를 보다 심도 있게 이해하고 전체적인 의미를 파악하는 데 도움을 주는 정보인 “맥락(Context)”과 도로교통을 의미하는 “Traffic”의 합성어이다. Traffic Context는 차량의 위치, 속도, 주변 차량의 행동, 신호등 상태, 도로 상황 등 여러 요소를 포함할 수 있으며, 이러한 정보는 교통 흐름 개선, 사고 감소, 운전자의 안전 향상 등을 위해 사용될 수 있다(Mozaffari et al., 2022; Wissing et al., 2017; Xue et al., 2022). 본 연구에서는 Traffic Context 중에서 차량의 위치, 속도, 주변 차량의 행동을 활용하였으며 차량과 차량 간의 상호작용으로 인한 차로 변경을 확인하고자 한다.

본 절에서는 YOLOv8 모델을 통해 획득한 정보로부터 영상처리 기법을 활용하여 차량의 차로 변경 기동에 영향을 주는 다양한 Traffic Context를 추출하는 방법에 대해 설명한다.

1) Ego Vehicle에 따른 Surrounding Vehicles 선정 방법

본 연구에서는 EV(Ego Vehicle) 주변의 상황을 분석하기 위해 SoI(Scope of Influence) 개념을 도입한다. SoI는 EV 주변의 차량을 정의 및 추출하기 위한 영역으로 Figure 6에서 빨간색 경계로 표시된다. SoI 내 차량들인 주변 차량(Surrounding Vehicles, SV)은 EV의 차로 변경에 직접적인 영향을 미칠 가능성이 높기 때문에, 이를 효과적으로 추출하고 분석하기 위해 SoI를 사용한다.

먼저, EV의 중심 좌표를 기준으로 프레임마다 SoI를 적용하여 SV를 추출한다. SoI의 크기는 종 방향으로 약 80m, 횡 방향으로 약 14m를 포함하는 300*50 pixel로 설정하였다. SoI의 종 방향 크기는 차량 간의 안전거리를 고려하였다. 차량 속도에 따른 안전거리는 속도 60km/h 이하에서 약 33.33m, 속도 70km/h 이하에서 약 38.89m이다(Lertworawanich, 2006). 연구에 활용한 도로는 도시 부 일반 도로의 편도 2차로 이상의 도로이며 제한 속도는 60km/h이다. 도로에 대한 제한 속도와 과속에 대한 추가적인 상황을 고려하여 적절한 차간 거리를 40m로 설정하였다. EV의 종 방향 기준 전방 약 40m, 후방 약 40m로 총 약 80m인 300 pixel을 SoI로 지정하였다. SoI의 횡 방향 크기는 50 pixel, 약 18m로 세 개의 차선을 전부 포함하도록 하였다. Figure 6은 EV에 따른 SV의 위치 명칭을 나타낸 것이며, EV를 기준으로 선행 차량을 Preceding Vehicle(PV), 오른쪽 선행 차량을 Right Preceding Vehicle(RPV), 왼쪽 선행 차량을 Left Preceding Vehicle(LPV)로 명명한다. 또한, 이와 같은 기준으로 후방 차량의 경우 Following Vehicle(FV), 오른쪽 후방 차량을 Right Following Vehicle(RFV), 왼쪽 후방 차량을 Left Following Vehicle(LFV)로 명명한다.

2) 상대 속도 및 거리 추출 방법

앞서 추출한 SV와 좌표, 속도 정보를 통하여 EV와의 상대 속도와 거리를 계산한다. 상대 종 방향 속도를 구하는 식은 Equation 7과 같다. EV의 종 방향 속도와 각 SV들의 종 방향 속도로 상대 속도를 구한다. 상대 횡 방향 속도를 구하는 식은 동일하며, 횡 방향 속도를 통해 계산할 수 있다.

차량 간의 거리를 계산하기 위해 위에서 구한 front 좌표와 rear 좌표를 활용하였고, 유클리드 거리(Euclidean Distance)를 사용하여 계산한다. EV와 전방 차량과의 거리를 구하기 위해 EV의 front 좌표와 전방 차량의 rear 좌표를 사용하였고, 후방 차량과의 거리는 EV의 rear 좌표와 후방 차량의 front 좌표를 통해 계산한다.

4. Transformer 기반의 차로 변경 예측 모델

본 절에서는 본 논문의 핵심인 Traffic Context를 활용한 Transformer 기반 차로 변경 예측 모델에 관하여 설명한다. 이전 절에서 설명한 방법을 통해 획득한 데이터를 바탕으로 약 24개의 특징을 Transformer의 입력 변수로 사용하였다(Table 2 참조). 주변 차량의 거리와 속도가 차로 변경에 영향을 미치기 때문에(Jokhio et al., 2024; Luo et al., 2016) 해당 변수들을 선정하였으며, EV 정보와 Traffic Context 정보가 입력 변수로 구성되어 있다. EV의 정보는 프레임마다 EV의 ID, 속도, 가속도가 포함되어 있으며, Traffic Context 정보는 EV와 SV 간의 상대 속도와 상대 거리로 구성되어 있다. Transformer의 예측 변수로는 차로 변경 의도인 차로 변경과 차로 유지가 있으며, 이를 모델 학습에 적용하기 위해서 One-Hot Encoding을 활용하여 차로 변경은 1, 차로 유지는 0으로 설정하였다.

Table 2.

Input indicators of the model

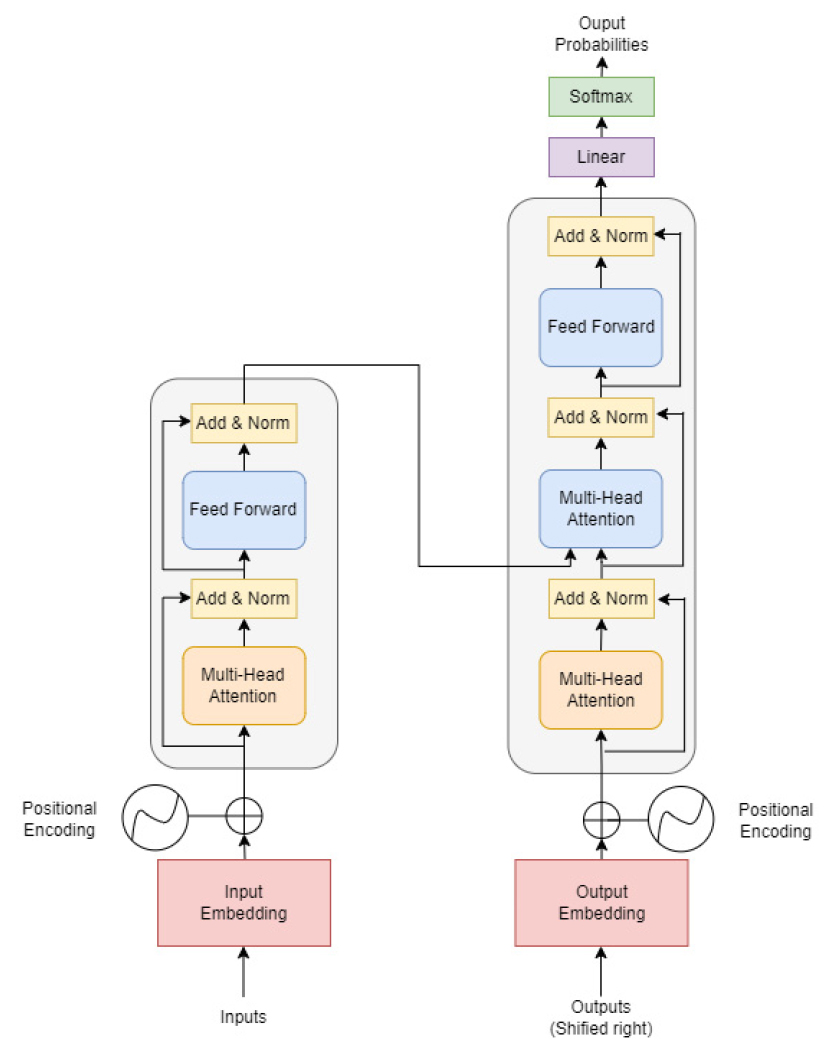

Figure 7은 본 연구에서 활용한 Transformer 기반 모델의 전반적인 구조를 보여준다. 제안하는 모델은 기본적인 Transformer의 입-출력 구조인 인코더(Encoder)-디코더(Decoder) 형태를 채택하였으며, 인코더는 입력 시퀀스를 고정된 길이의 벡터로 변환하는 역할을 하고, 디코더는 이 벡터를 통해 차로 변경 여부를 예측하는 역할을 한다. 각 인코더와 디코더는 여러 개의 층(Layer)으로 구성되며, 각 층은 Multi-Head Attention 메커니즘과 Feed-Forward 신경망으로 구성된다.

Multi-Head Attention 메커니즘은 입력 데이터의 다양한 위치에서 정보를 동시에 집중할 수 있게 하여, 시퀀스 내의 복잡한 의존성을 모델링하는데 매우 효과적이다. 차로 변경 시 현재 주행 중인 차선과 변경하려는 차선을 제외한 나머지 차선은 상대적으로 고려 대상이 아니며 중요도가 떨어진다. 이처럼 차로 변경 예측에서는 차량의 현재 상태와 주변 차량의 동적인 상태 사이의 복잡한 상호작용을 학습하는 데 중요하다. Multi-Head Attention을 통해 모델은 주변 차량 움직임의 변화에 따른 차로 변경 가능성을 더 정확히 예측하도록 한다.

Transformer 모델은 기본적으로 순서 정보를 처리할 수 없어서 Positional Encoding을 도입하여 시퀀스의 위치정보를 모델에 제공한다. 차로 변경 예측에서는 시간적 순서가 매우 중요하므로, 각 입력 데이터에 Positional Encoding을 추가함으로써 시간적 컨텍스트를 효과적으로 모델에 반영할 수 있다. 디코더의 최종 출력층은 시퀀스의 각 위치에 대한 차로 변경 가능성을 나타내는 확률 분포를 생성한다. 이는 Softmax 함수를 사용하여 계산되며, 최종적으로 모델은 각 시점에서 차로 변경 여부를 예측한다. Grid Search 기법으로 설정한 모델 학습 하이퍼파라미터는 Table 3과 같다.

실험 결과

1. 평가 지표

본 장은 앞서 객체 탐지를 위해 학습시킨 모델과 차로 변경 예측 모델의 성능 평가에 활용되는 지표를 설명한다. mAP(mean Average Precision)은 객체 검출 및 분류 작업에서 모델 성능을 평가하는 지표이다. 각 클래스에 대한 AP(Average Precision) 점수의 평균을 나타내며, 모델이 여러 클래스 간의 구분을 얼마나 잘 수행하는지를 반영한다. AP는 Precision-Recall 그래프에서 선 아래의 면적을 나타내는 지표이다. Precision은 모델이 예측한 차로 변경 상황 중 실제로 차로 변경이 발생한 비율을 측정하는 지표이다. Recall은 실제로 발생한 차로 변경 상황 중 모델이 올바르게 예측한 비율을 나타낸다. F1-score는 Precision과 Recall의 조화평균으로, 두 지표 간의 균형을 평가한다. Accuracy는 모델이 올바르게 예측한 사례의 비율을 나타내며, 전체 데이터 중 모델이 정확히 예측한 비율을 의미한다. 각 평가 지표에 대한 수식과 설명은 Table 4와 같다.

Table 4.

Evaluation metrics and their formulas for model performance assessment

2. 검출 모델 성능 평가

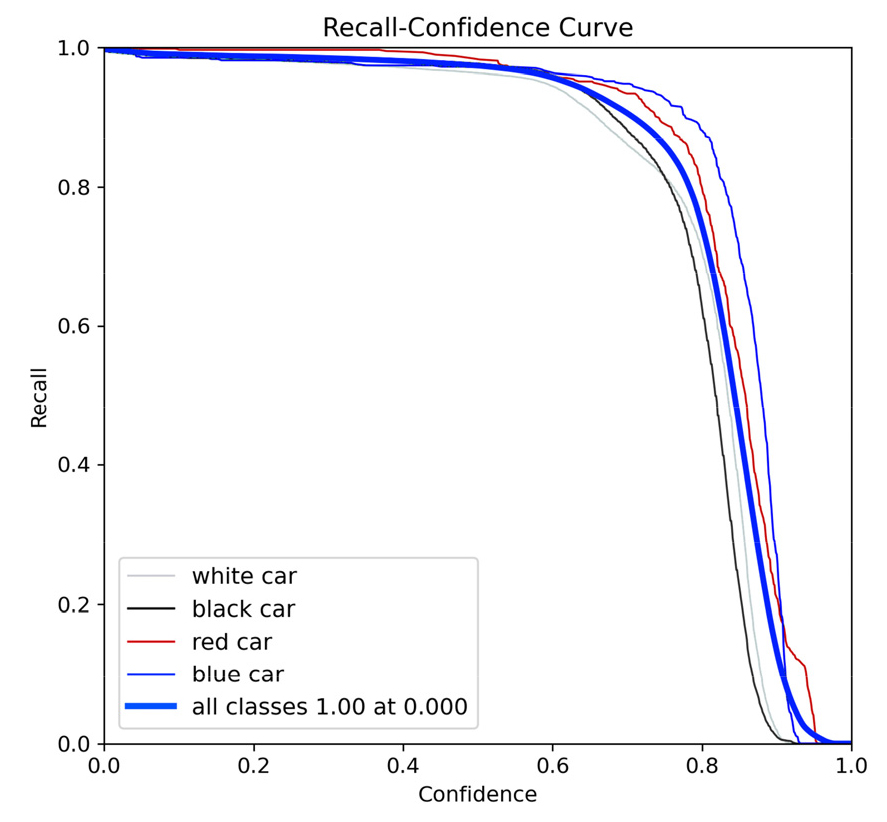

Table 5는 YOLOv8 모델의 객체 검출 성능을 나타낸 것이다. 본 모델은 mAP50-95에서 0.75, mAP50에서는 약 0.99의 높은 성능을 보였다. 이는 모델이 매우 높은 정확도로 객체를 검출할 수 있다는 것을 의미한다. 또한, Precision과 Recall은 각각 약 0.98, 0.99로 측정되었으며, 이는 검출된 객체와 실제 객체 간 매우 높은 일치도를 보임을 의미한다. Figure 8은 다양한 클래스에 대한 Recall-confidence curve를 나타내며, 모든 클래스에 대해 거의 1.0에 가까운 Recall 값을 보여준다. 이는 모델이 다양한 색상의 차량에 대해 높은 감지 성능을 유지할 수 있음을 나타내며, 특히 도로 색상과 유사한 검은색 차량에 대하여 제대로 감지하는 것을 보아 우수한 성능을 확인할 수 있다.

3. 차로 변경 예측 모델 성능 평가

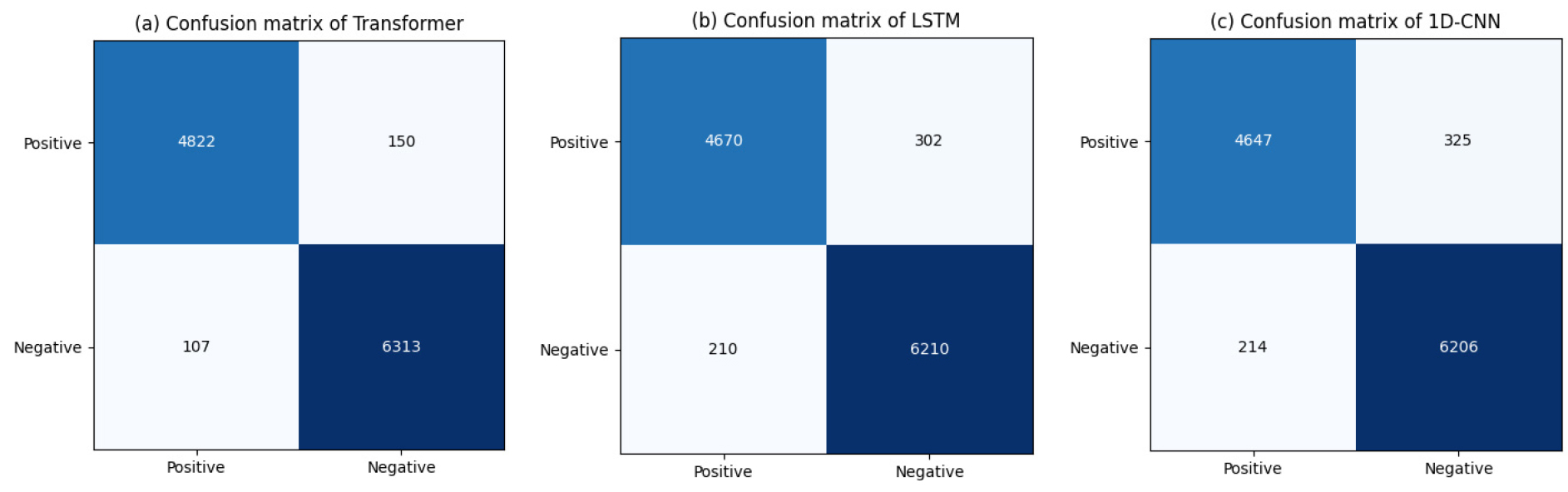

본 연구에서는 차로 변경 예측을 위해 LSTM(Long Short-Term Memory), 1D-CNN(1-Dimensional Convolutional Neural Network), Transformer 모델을 평가하였다. Table 6은 모델별 차로 변경 예측 성능을 비교한 것이다. Transformer 모델은 모든 평가 지표에서 가장 높은 성능을 보였다. Accuracy는 0.977, F1-score는 0.974, Precision은 0.978, 그리고 Recall은 0.969로 측정되었다. 이는 Transformer가 차로 변경과 차로 유지 모두에서 높은 수준의 예측 정확성을 달성했음을 알 수 있다. LSTM과 1D-CNN 모델은 각각 0.955와 0.952의 Accuracy를 기록하며, Transformer와 약 0.02의 정확도 차이를 보인다. 근소한 차이지만 약 0.95에서 약 0.97의 정확도 상승을 이끌어내는 것은 고난도의 문제이며 이를 고려하였을 때 Transformer의 준수한 성능을 확인할 수 있다. Figure 9는 모델별 혼동 행렬을 나타낸다. 전반적으로 모든 모델이 차로 변경과 유지를 잘 분류하지만, Transformer가 다른 두 모델에 비해 가장 적은 오분류를 보임으로써 우수한 성능을 확인하였다.

결론 및 고찰

본 연구에서는 YOLOv8 모델을 활용하여 드론의 탑 뷰 영상으로부터 차량을 검출하고, 이를 바탕으로 도로 위 차량의 차로 변경 예측을 수행하는 새로운 방법론을 제시하였다. 제안하는 방법론은 객체 탐지를 위한 YOLOv8 모델, 영상처리 기법을 활용한 Traffic Context 추출, Transformer 기반의 차로 변경 예측 모델로 구성되며, 제안하는 방법론의 성능 검증을 위하여 대전 유성구 구성동 도로 일대에서 드론 촬영 영상을 활용하고, 프로토타입 수준의 모델 구축 및 학습/검증을 진행하였다.

실험 결과를 요약하자면, YOLOv8을 활용한 차량 검출 모델은 mAP50에서 약 0.99로 우수한 성능을 보임으로써, Traffic Context 데이터 추출의 높은 신뢰성을 확인하였다. 또한, 차로 변경 예측 모델은 transformer가 약 0.98의 정확도를 가지며, 최소한의 오분류로 가장 우수한 예측 성능을 보였다. 이는 해당 모델이 차로 변경 상황을 정확하게 인식하는 데 매우 효과적임을 시사한다.

그러나 본 연구에서는 도로 상황과 드론에 대한 한계점이 존재한다. 먼저, 분석 대상으로 활용한 도로는 도시부 도로 환경에서 신호등, 이면도로 진출입, 불법 주정차 등의 다양한 요인에 대한 영향을 배제한 한정된 도로 조건에 근거하기 때문에, 제안하는 연구만을 활용하여 모든 도로에서의 Traffic Context에 대한 모델 성능을 일반화하는 것은 무리가 있다. 또한, 트럭, 버스, 오토바이 등의 다양한 차량 유형을 고려하지 않고 일반 차량을 대상으로만 진행한 연구이기 때문에 다양한 교통수단과 상황에 대한 설명력이 부족하다. 따라서 본 연구에서 제안하는 방법론을 활용하여 정확하고 설득력 있는 정보를 얻기 위해 다양한 도시부 도로 환경과 차량 유형에 대한 상황들을 통해 분석이 수행되어야 할 것으로 생각된다. 또한, 다양한 변수 중에서도 차로 변경 시 어떤 변수에 집중하였는지를 확인하기 위해 Attention Mechanism을 활용하여 차로 변경에 대한 특정 Traffic Context 변수가 미치는 직접적인 영향을 분석할 필요가 있다고 생각된다. 드론은 배터리 용량의 한계로 인해 장기간의 자료 취득이 어려우며, 기상 상황에 민감하기 때문에 원활한 영상 취득에 차질이 생길 수 있다. 이는 향후 드론 기술의 발전을 통한 개선 가능성이 존재한다고 생각된다.

본 연구는 최신 객체 탐지 기술인 YOLOv8을 활용하여 교통 상황 인식의 정확성과 효율성을 향상 시켰으며, 다양한 형태의 차량을 정확하게 식별하였다. 드론을 사용하여 센서나 CCTV로 확인하기 어려운 전체적인 교통 흐름과 Traffic Context를 파악하였으며, 교차로나 합류 지점과 같이 도로 관측 및 측정이 까다로운 다양한 구간에 대해 드론의 활용 가능성을 확인하였다. 또한, 시뮬레이션이 아닌 실제 도로 상황의 영상을 사용하여 데이터를 수집하고 분석을 진행함에 따라 Transformer 기반 차로 변경 예측 모델이 현실적인 교통 흐름과 변수들을 고려할 수 있게 하여 보다 신뢰성 높은 결과를 도출하는데 기여하였다. 이는 본 연구에서 제안한 방법론이 실제 도로 상황에 적합하게 적용할 수 있음을 시사하며, 향후 효율적인 교통 흐름 관리, 자율 주행 차량의 경로 예측을 위한 자료로 활용되어 교통 시스템 개선과 도로 안전성 향상에 기여할 수 있을 것으로 기대된다.